Kafka 的事务机制是如何实现的?

Kafka

分布式事务

Exactly-Once

消息可靠性

什么是 Kafka 事务?

Kafka 事务是保证跨多个消息分区原子性操作的机制。它确保一组消息要么全部成功提交(类似数据库事务的提交),要么全部回滚(类似事务回滚)。核心特点包括:

- 原子性保证:即使消息分布在不同的 Topic 分区,也能保证整体提交或回滚

- 分布式协调:通过事务协调器统一管理事务状态

- 端到端一致性:从生产者发送到消费者读取的全链路一致性控制

类比银行转账场景:当需要同时更新A账户(分区1)和B账户(分区2)时,事务机制确保这两个更新操作要么同时成功,要么同时失败,避免出现中间不一致状态。

事务的核心组件

1. 事务协调器(Transaction Coordinator)

核心职责:

- 唯一ID分配:为每个新事务生成全局唯一标识

- 状态跟踪:实时记录事务生命周期状态(进行中/已提交/已中止)

- 事务仲裁:协调所有参与分区的提交或回滚操作

- 超时监控:检测未及时完成的事务并触发自动中止

2. 事务日志(Transaction Log)

关键特性:

- 专用存储:使用

__transaction_state内部主题存储 - 持久化保障:所有状态变更持久化到磁盘

- 高可用性:通过多副本机制确保数据安全

- 完整追溯:记录事务从创建到终结的全过程

3. 控制消息(Control Messages)

消息类型与作用:

| 类型 | 触发时机 | 功能说明 |

|---|---|---|

| BEGIN | 事务启动时 | 标识事务开始边界 |

| PREPARE | 提交准备阶段 | 通知参与者进入准备状态 |

| COMMIT | 所有参与者确认后 | 最终确认事务提交 |

| ABORT | 出错或超时 | 终止事务并回滚所有操作 |

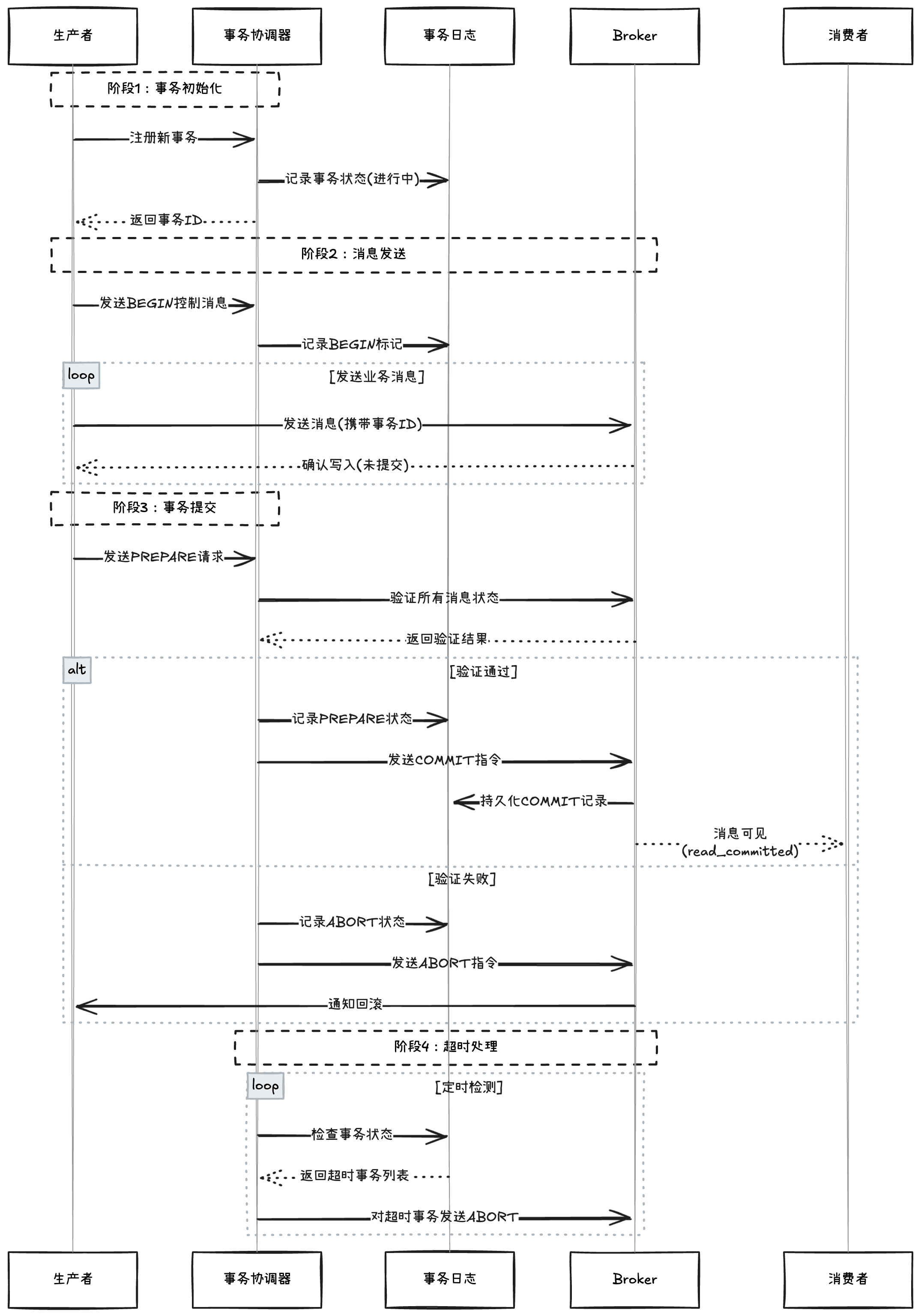

事务流程详解

完整事务生命周期

-

初始化阶段

- 生产者向协调器注册

- 分配 Producer ID 和 Epoch

-

消息发送阶段

- 发送 BEGIN 控制消息

- 写入业务消息(携带事务ID)

- 消息暂存于未提交状态

-

提交阶段

- 发送 PREPARE 消息到事务日志

- 等待所有副本确认

- 写入 COMMIT 标记使消息可见

-

超时处理阶段

- 协调器定时扫描未完成事务(间隔由

transactional.id.expiration.ms控制) - 对超时事务自动发起 ABORT 流程

- 清理相关事务状态

- 通知生产者事务已中止

- 协调器定时扫描未完成事务(间隔由

Exactly-Once 语义的实现

1. 幂等性生产(Idempotent Producer)

# 生产者必须配置

enable.idempotence=true # 启用幂等性

acks=all # 需要所有副本确认

retries=2147483647 # 最大重试次数

2. 事务性消息(Transactional Messaging)

// Java 生产者示例

try (Producer<String, String> producer = new KafkaProducer<>(props)) {

producer.initTransactions();

producer.beginTransaction();

// 发送多条跨分区消息

producer.send(new ProducerRecord<>("orders", "order-1001"));

producer.send(new ProducerRecord<>("payments", "payment-1001"));

producer.commitTransaction();

} catch (KafkaException e) {

producer.abortTransaction();

}

配置与监控

1. 关键配置参数

# 事务超时时间(默认1分钟)

transaction.timeout.ms=60000

# 最大未完成事务数

max.in.flight.requests.per.connection=5

# 消费者隔离级别

isolation.level=read_committed

2. 监控指标

核心监控指标说明:

| 指标名称 | 监控重点 | 正常范围 | 告警阈值建议 |

|---|---|---|---|

| active-transactions-count | 当前活跃事务数量 | 根据集群规模动态变化 | 持续增长超过50% |

| transaction-timeout-rate | 每分钟事务超时次数 | 0-5次/分钟 | 连续3分钟超过10次 |

| transaction-commit-time | 事务提交耗时(P95) | < 500ms | 持续超过1000ms |

| abort-rate | 事务中止频率 | < 2% | 连续超过5% |

| prepare-phase-latency | PREPARE阶段延迟(平均值) | < 200ms | 持续超过500ms |

监控建议:

- 设置活跃事务数的基线告警

- 跟踪事务提交时间的百分位值

- 关联超时率与系统负载指标

- 对中止事务进行根因分析

常见问题及解决方案

1. 事务超时(Transaction Timeout)

问题现象:

- 日志中出现大量

ProducerFencedException - 监控显示

transaction-timeout-rate持续升高

主要原因:

- 事务处理时间超过

transaction.timeout.ms设置 - 消费者处理速度跟不上消息生产速度

- 网络延迟导致心跳包未及时到达协调器

解决方案:

# 调整生产者配置

transaction.timeout.ms=120000 # 适当延长超时时间

max.block.ms=60000 # 增加阻塞等待时间

- 优化消息处理流水线,减少单事务处理时间

- 监控并优化消费者端的

max.poll.interval.ms

2. 事务性能瓶颈(Performance Bottleneck)

问题现象:

- 生产者吞吐量明显下降

- Broker 的 CPU 使用率异常升高

- 监控显示

transaction-commit-time持续增长

主要原因:

- 事务范围过大(包含过多消息)

- 频繁的小事务提交

- 副本同步延迟导致提交等待

优化方案:

# 调整生产者配置

batch.size=262144 # 增大批次大小(256KB)

linger.ms=20 # 适当增加等待时间

compression.type=lz4 # 启用压缩

- 将大事务拆分为多个小事务(建议单事务包含 100-500 条消息)

- 使用异步提交配合回调处理

3. 重复消费问题(Duplicate Consumption)

问题现象:

- 消费者日志出现重复处理记录

- 业务数据出现不一致状态

- 监控显示

abort-rate异常波动

主要原因:

- 事务提交后消费者未及时提交 offset

- 消费者 rebalance 导致位移重置

- 生产者重试导致消息重复

解决方案:

// 消费者端幂等处理示例

if (!processedOffsets.contains(record.offset())) {

processRecord(record);

processedOffsets.add(record.offset());

consumer.commitSync();

}

- 启用消费者的

enable.auto.commit=false - 实现业务层的幂等处理逻辑

- 设置

isolation.level=read_committed

小结

Kafka 事务机制通过协调器、事务日志和控制消息的配合,实现了跨分区的原子性操作。配合幂等性生产,最终可以实现 Exactly-Once 语义。

相关推荐: